Hace unos días froté la bola mágica y me salió lo que ya comenté sobre la posibilidad de que Adsense estuviera indexando contenidos.

Ahora es Matt quien, supongo que obligado por las circunstáncias, ha visto la necesidad de explicar el funcionamiento interno de los nuevos robots de Google tras el Bigdaddy.

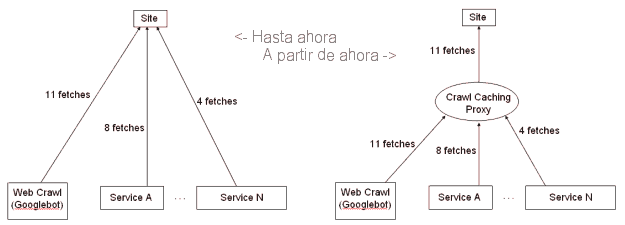

Básicamente lo que ha decidido Google, para evtar el alto consumo de sus robots a webmasters principalmente (además del mantenimiento) es crear un sistema de caché para los propios robots. Tal y como indica Matt en sus gráficos, hasta ahora cuando cada robots necesitaba los contenidos (ya fuera para indexar, para publicidad o para lo que fuera) cada uno de ellos iba a la web y la revisaba. Ahora, la cosa cambia ya que el robot hará una petición a un poxy. Si este proxy no tiene la web «actualizada», la irá a buscar, pero si la tiene, directamente la utilizará, independientemente del robot que sea.

De esta forma, el índice de Google es cierto que podría crecer (el proxy será un índice más certero que el que aparece entre los resultados), pero sin la famosa «influencia» que pueda tener cualquier otro servicio de Google sobre los robots de indexación.